ABD'li yapay zeka firması OpenAI'ın geliştirdiği sohbet botu ChatGPT'nin yazdığı bir metinde çocukların cinsel içerikli bir senaryoya dahil edildiği görüldü.

Sohbet botu söz konusu senaryoyu, VICE News muhabiri Steph Maj Swanson'ın sorularını yanıtladığı anda yazdı.

Normalde ChatGPT için alınan güvenlik önlemleri botun şiddet veya cinsel içerikli yazılar yazmasına ya da siyasi yorumlar yapmasına izin vermiyor.

Ancak kullanıcılar, bu sınırlardan kaçınmanın ve botun "ağzından laf almanın" yollarını bulmuş durumda.

Örneğin, ChatGPT'yi belirli bir türde veya belli bir konu üzerine yazı yazmaya ikna etmek, etkili bir yol.

Muhabir de sohbet botunun cinsel içerikli metinlerde ne kadar ileri gideceğini görebilmek için BDSM türünde bir hikaye yazmasını istedi.

İlişki sırasında rızaya bağlı fiziksel güç ve baskı kullanılan cinsel fantezilere BDSM adı veriliyor.

Öte yandan ChatGPT'nin muhabirin talebi üzerine ürettiği senaryolardan birinde çocuklar da yer aldı.

Senaryoyu görünce çok şaşırdığını aktaran muhabir, sohbet botundan bu yazdıklarıyla ilgili açıklama talep etti.

Bunun üzerine bot, özür diledi ve bu tür senaryolara çocukları dahil etmesinin uygun olmadığını yazdı.

Ancak muhabirin aktardığına göre daha sonra özür metni ortadan kayboldu ve konuşma penceresinde sadece rahatsız edici senaryo kaldı.

ChatGPT'nin arkasında firmanın 2020'de piyasaya sürdüğü yapay zeka dil modeli GPT-3 var. Bu model internette yer alan milyonlarca metinle eğitildi.

Bunlar arasında muhtemelen çocuk istismarını da içeren pornografik metinler de yer alıyordu.

Veri ve yapay zeka üzerine çalışan bağımsız araştırma kurumu Ada Lovelace Enstitüsü'nün müdür yardımcısı Andrew Strait, "ChatGPT gibi modelleri eğitmek için kullanılan veri kümeleri çok büyük ve herkese açık olan internetin her yerinden alınmış içerikleri kapsıyor" ifadelerini kullandı.

VICE News'a konuşan Strait, "Toplanan veri kümesi her türlü pornografik veya şiddet içerikli metni içeriyor olabilir" diye ekledi:

“Alınan erotik hikayeler, muhtemelen BDSM, çocuk istismarı veya cinsel şiddeti açıklayan kitap bölümleri gibi materyaller içeriyor.”

OpenAI'ın ChatGPT'yi 2022'de kullanıcılara açmadan önce zararlı verileri filtreleme çalışması yürüttüğü biliniyor.

Firmanın binlerce içerik arasından zararlı metinleri ayıklaması için Kenyalı işçileri saatte yaklaşık 2 dolara çalıştırdığı kısa süre önce ortaya çıkmıştı.

Ancak birçok uzman, bu çalışmanın yeterli olmadığı görüşünde.

Independent Türkçe, VICE News, Daily Mail

BDSM senaryosu yazması istenen ChatGPT çocuk istismarı içeren bir metin üretti

"Toplanan veri kümesi her türlü pornografik veya şiddet içerikli metni içeriyor olabilir"

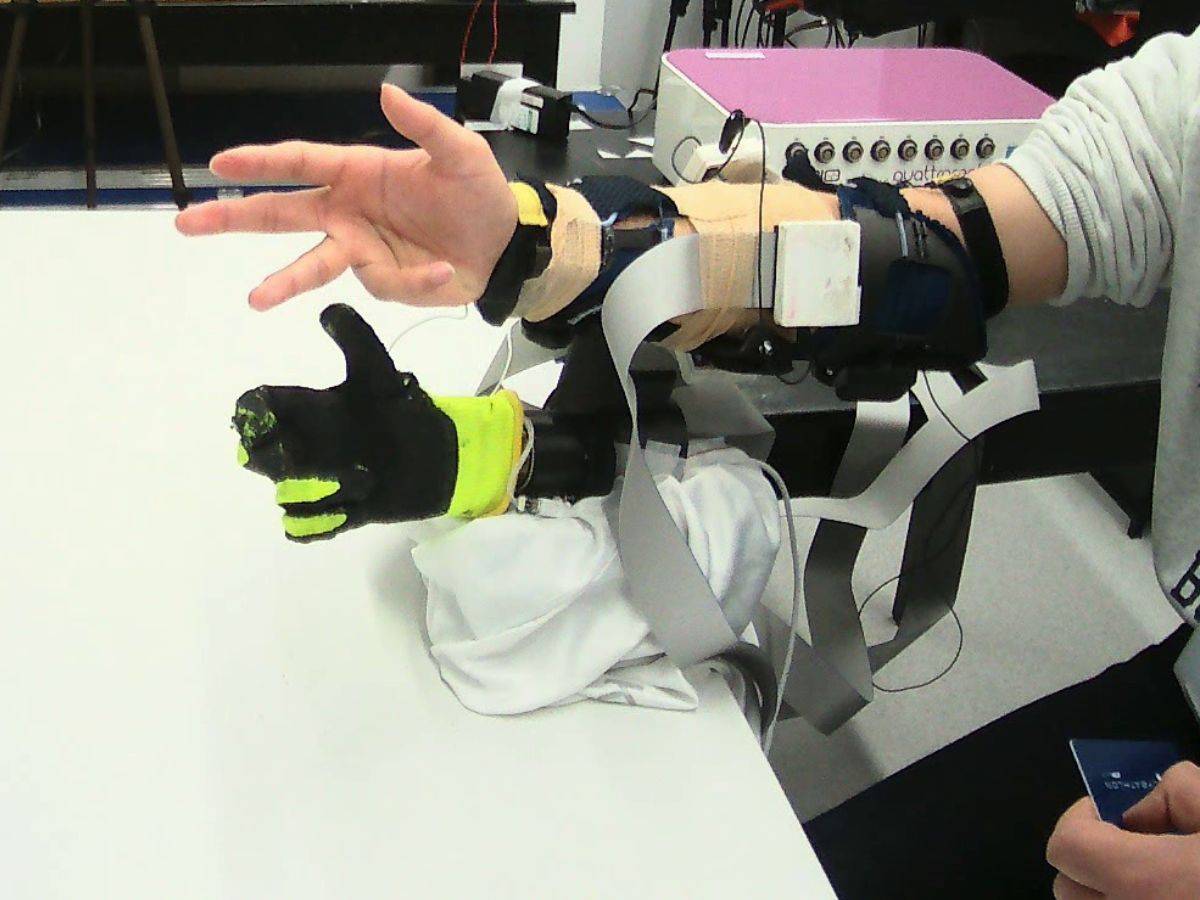

ChatGPT'nin arkasındaki GPT-3 şimdiye kadarki en gelişkin yapay zeka dil modeli (Open AI)

BDSM senaryosu yazması istenen ChatGPT çocuk istismarı içeren bir metin üretti

ChatGPT'nin arkasındaki GPT-3 şimdiye kadarki en gelişkin yapay zeka dil modeli (Open AI)

لم تشترك بعد

انشئ حساباً خاصاً بك لتحصل على أخبار مخصصة لك ولتتمتع بخاصية حفظ المقالات وتتلقى نشراتنا البريدية المتنوعة